-

- ai音乐生成AI音乐平台音乐大模型ai音乐创作文生音乐InspireMusicInspireMusic是由阿里巴巴通义实验室开源的音乐生成技术,旨在打造一个集音乐生成、歌曲生成和音频生成能力为一体的开源 AIGC 工具包。它基于多模态大模型技术,支持通过简单的文字描述或音频提示快速生成多种风格的高质量音乐作品。

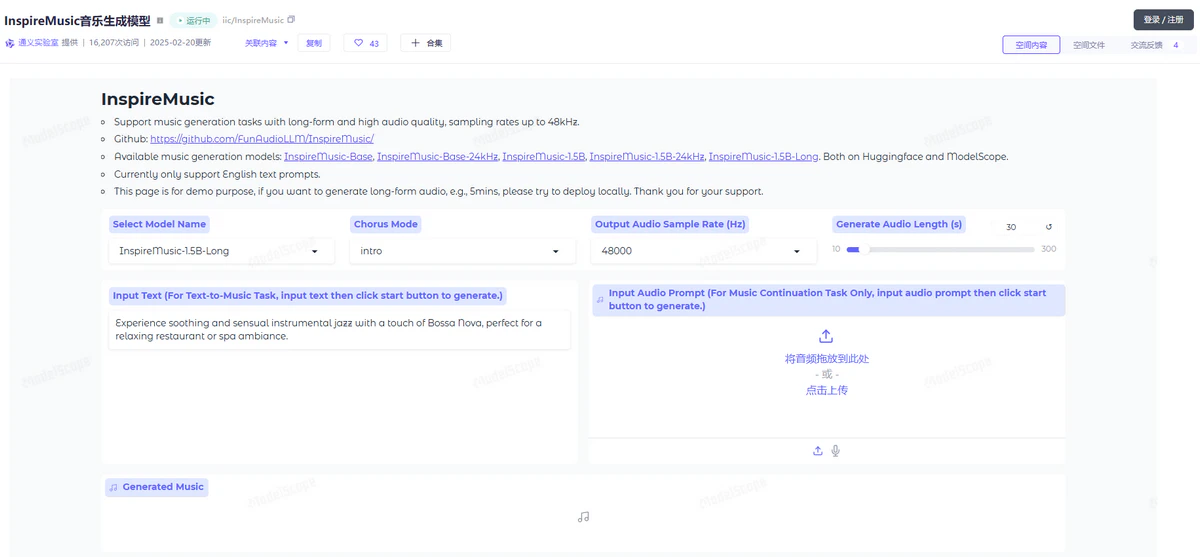

InspireMusic是由阿里巴巴通义实验室开源的音乐生成技术,旨在打造一个集音乐生成、歌曲生成和音频生成能力为一体的开源 AIGC 工具包。它基于多模态大模型技术,支持通过简单的文字描述或音频提示快速生成多种风格的高质量音乐作品。

核心功能

- 文本到音乐的生成:用户可以通过简单的文字描述生成符合需求的音乐作品。

- 音乐结构和风格控制:支持通过音乐类型、情感表达和复杂的音乐结构标签来控制生成的音乐。

- 高质量音频输出:支持多种采样率(如24kHz和48kHz),能够生成高音质的音频。

- 长音频生成:支持生成超过5分钟的长音频。

- 灵活的推理模式:提供fast模式(快速生成)和高音质模式,满足不同用户的需求。

- 模型训练和调优工具:为研究者和开发者提供丰富的音乐生成模型训练和调优工具。

如何使用

GitHub 仓库:https://github.com/FunAudioLLM/InspireMusic

ModelScope:https://modelscope.cn/studios/iic/InspireMusic/summary

HuggingFace:https://huggingface.co/spaces/FunAudioLLM/InspireMusic

项目特点

- 统一的音频生成框架:支持音乐、歌曲及音频的生成,为用户提供多样化选择。

- 灵活可控的生成:基于文本提示和音乐特征描述,用户可精准控制生成音乐的风格和结构。

- 简单易用:简便的模型微调和推理工具,为用户提供高效的训练与调优工具。

- 社区驱动:面向研究人员、开发者和爱好者,打造协作创新的开放平台,鼓励共同进步。

- 开源透明:开源代码、算法和模型,供全球开发者学习和使用。

技术原理

InspireMusic 的核心架构包括音频 tokenizer、自回归 Transformer 模型、扩散模型(CFM)和 Vocoder。它通过具有高压缩比的单码本 WavTokenizer 将输入的连续音频特征转换成离散音频 token,然后利用基于 Qwen 模型初始化的自回归 Transformer 模型预测音频 token,再由 CFM 扩散模型重建音频的潜层特征,最终通过 Vocoder 输出高质量的音频波形。

- 音频Tokenizer:通过高压缩比的单码本WavTokenizer,将输入的连续音频特征转换为离散的音频token,支持模型处理的音频数据格式。

- 自回归Transformer模型:该模型基于Qwen模型进行初始化,用于根据文本提示预测音频token,能够理解并生成与文本描述匹配的音乐序列。

- 扩散模型(Conditional Flow Matching, CFM):用于从生成的音频token中恢复高质量音频特征,增强音乐生成的连贯性和自然度。

- Vocoder:将重建后的音频特征转换为高质量的音频波形,最终输出音乐作品。它支持多种采样率(如24kHz和48kHz),并能够生成超过5分钟的长音频作品。

数据统计

特别声明&浏览提醒

本网站提供的「InspireMusic」相关内容均来源于网络搜集整理,不保证跳转外部链接的准确性和完整性。网站外部链接的内容在[2025-06-07]录入之前合规合法,后期网站的内容如出现违规或者损害了您的利益,可以直接联系网站管理员进行删除。如果涉及到金钱交易,请仔细甄别,避免上当受骗!

AI工具

热门标签

ai创作(14) 虚拟人像(1) 智能体模型(8) ai文生视频(31) ai对话工具(43) 人工智能模型(3) ai聊天(41) CogAgent(1) ai大模型(17) 文本转语音(25) 声音克隆(11) ai翻译工具(18) 语音合成(8) 大语言模型(6) ai编程(27) 智能编码(5) 文档生成(1) 大模型(13) ai语音生成(13) ai开发工具(4) ai论文助手(9) ai视频精修(8) AI编程助手(20) AI添加字幕(1) 自然语言处理(9) ai搜索(11) 智能编程助手(6) 电脑智能体(1) 多模态(18) ai机器人(5)

SkyReels-V2和SkyReels-V1相比,

SkyReels-V2和SkyReels-V1相比, Claude 4有什么特点,为什么

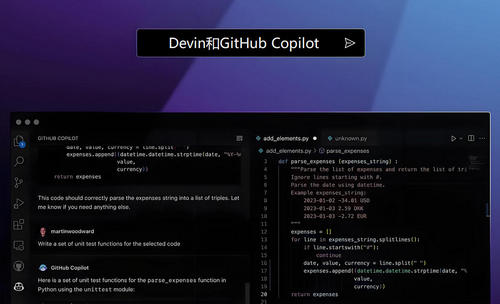

Claude 4有什么特点,为什么 Devin与GitHub Copilot相比有哪

Devin与GitHub Copilot相比有哪 MCP是什么?为什么说谁把

MCP是什么?为什么说谁把